在现代数据中心中,负载均衡器是必不可少的组件,用于管理大型流量并确保应用程序高可用性。手动部署和管理负载均衡器可能是一项繁琐且容易出错的任务,尤其是在大规模环境中。

为了解决这些挑战,自动化负载均衡器部署和管理已变得至关重要。通过使用脚本和工具,IT 团队可以简化任务、减少人为错误并提高运营效率。

负载均衡器原理

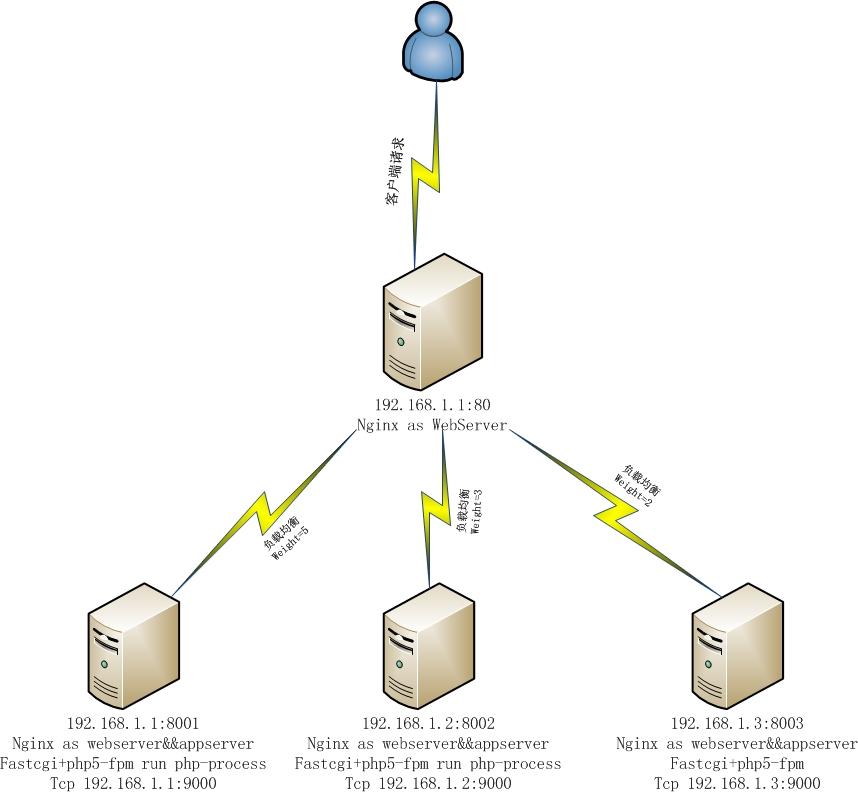

在深入探讨自动化之前,让我们快速了解一下负载均衡器的基本原理。负载均衡器充当流量控制器,将来自客户机的传入请求分布到多个服务器或服务实例上。

负载均衡器使用各种算法来决定将请求发送到哪台服务器,例如:

- 轮询:请求按顺序分配给服务器。

- 最少连接:请求分配给当前连接数最少的服务器。

- 加权轮询:请求根据服务器的处理能力分配,权重较高的服务器接受更多请求。

自动化负载均衡器部署

自动化负载均衡器部署涉及使用脚本或工具来执行以下任务:

- 创建负载均衡器。

- 配置负载均衡器设置,例如算法、监听端口和服务器池。

- 将服务器添加到服务器池。

- 验证负载均衡器是否正常工作。

通过自动化这些步骤,IT 团队可以显著减少部署时间和错误。

自动化负载均衡器管理

除了部署之外,自动化还可以简化负载均衡器管理任务,例如:

- 监控负载均衡器:自动化工具可以持续监控负载均衡器的运行状况、服务器健康状况和流量模式。

- 自动扩展:当负载超过特定阈值时,自动化可以自动扩展服务器池以满足需求。

- 故障转移:如果服务器发生故障,自动化可以自动将流量转移到其他健康服务器。

- 配置更新:自动化可以简化负载均衡器配置更新,例如更改算法或添加新服务器。

通过自动化这些任务,IT 团队可以节省大量时间和精力,同时提高负载均衡器的整体可靠性和可用性。

脚本和工具

有多种脚本和工具可用于自动化负载均衡器部署和管理。一些流行的选项包括:

- Terraform:一种基础设施即代码工具,用于管理云资源,包括负载均衡器。

- Ansible:一种配置管理工具,用于自动化 IT 任务,包括负载均衡器的部署和管理。

- AWS CLI:亚马逊网络服务 (AWS) 的命令行界面,用于管理 AWS 资源,包括负载均衡器。

- Kubernetes:一个容器编排平台,允许通过 Kubernetes 对象管理负载均衡器。

选择合适的脚本或工具取决于特定的云环境、负载均衡器供应商和组织的独特需求。

结论

负载均衡器自动化对于简化部署和管理、提高效率和提高可用性至关重要。通过使用脚本和工具,IT 团队可以自动化繁琐的任务,减少错误并提高云基础设施的操作灵活性。

随着云计算的不断发展,预计负载均衡器自动化将变得更加重要。通过拥抱自动化,组织可以充分利用云的优势,提供高度可用且可扩展的应用程序和服务。