一、引言

随着人工智能(AI)技术的飞速发展,高性能计算(HPC)在诸多领域的应用日益广泛。

AI服务器在运行过程中产生的巨大热量成为了制约其性能发挥的关键因素。

为了解决这一难题,液冷技术应运而生,为AI服务器散热领域带来了革命性的突破。

本文将详细介绍液冷技术在AI服务器散热方面的应用及其助力高性能计算的重要性。

二、背景分析

1. 高性能计算的挑战:随着AI技术的不断进步,高性能计算面临着越来越大的挑战。服务器在运行大规模算法和数据处理任务时,会产生大量热量,如果不能及时散发,将导致服务器性能下降,甚至损坏硬件设备。

2. 传统散热技术的局限性:传统的散热技术如风扇散热、热管散热等,在面临高性能计算的巨大热量时,往往难以应对。其散热效率无法满足高性能计算的需求。

3. 液冷技术的崛起:液冷技术作为一种新兴的散热技术,以其高效的冷却性能引起了广泛关注。液冷技术通过液体(如水、冷却液等)与发热部件进行热交换,将热量迅速带走,从而实现有效的散热。

三、液冷技术在AI服务器散热中的应用

1. 冷却液循环散热系统:液冷技术通过构建冷却液循环散热系统,将液体通过管道引入服务器内部,与发热部件如处理器、显卡等进行接触,将热量带走。这种散热方式具有更高的散热效率,能够显著降低服务器运行时的温度。

2. 精细化温控管理:液冷技术还可以实现精细化温控管理。通过精确控制液体的流量和温度,可以实现对服务器内部各个部件的精确温控,确保各部件在最佳温度下运行,从而提高服务器的性能和稳定性。

3. 模块化设计:液冷技术采用模块化设计,方便对服务器进行维护和升级。当某个部件出现故障或需要升级时,只需更换相应的液冷模块,而无需更换整个服务器。这大大降低了维护成本和升级难度。

四、液冷技术助力高性能计算

1. 提升计算性能:液冷技术能够有效降低服务器温度,确保高性能计算任务在最佳状态下运行。这将大大提高服务器的计算性能,加速AI算法的执行速度。

2. 节能环保:相比传统散热技术,液冷技术具有更高的能效比。它能够以更低的能耗实现更好的散热效果,有助于减少能源浪费,符合绿色环保的发展趋势。

3. 促进技术创新:液冷技术的发展将推动高性能计算的技术创新。在更好的散热效果下,服务器能够承担更复杂的计算任务,从而推动AI技术的不断进步。

五、AI服务器散热系统龙头股

在液冷技术助力高性能计算的背景下,一些企业已经在这一领域取得了显著成果,成为了AI服务器散热系统的龙头股。

这些企业不仅拥有先进的液冷技术,还具备强大的研发实力和市场份额。

随着液冷技术的普及和应用,这些龙头股有望在市场上取得更大的成功。

六、结论

液冷技术作为新兴的散热技术,在AI服务器散热方面带来了革命性的突破。

它以其高效的冷却性能,解决了高性能计算中的散热难题。

随着AI技术的不断发展,液冷技术将在高性能计算领域发挥越来越重要的作用。

相关企业应加大研发投入,推动液冷技术的进一步发展和应用,为高性能计算提供更强的支持。

为什么我断了waifai我怎么还会在好友手机上显示我是waifai在线

你的状态信息没有送到对方手机上而已,产生的原因有:1、服务器延迟。

你没有正常退出,直接关掉WiFi(不是waifai)连接,导致你与服务器失联,服务器程序不会立刻确认你下线了,要过一段时间才能确认。

如果服务器联系不到你,就认为你下线了。

并且你的网络比较卡,就会在线,离线来回闪。

所以服务器都设计成上面说的那样。

2、网络延迟。

服务器的状态确定后,也需要过一段时间再发给客户端。

发送的信息也不是立刻就能接收到。

3、手机客户端延迟。

手机客户端与服务器不可能一点时间差都没有。

例如,你的手机每隔1秒在服务器获取一次状态信息,那么0.5秒的状态可能就是不真实的。

如果刷新的过于频繁,用户这么多,服务的负担太重,所以刷新的设置时间间隔不会太短。

什么是云主机?宝德云主机怎么样?

宝德云服务器优点:高性能:云端大型服务器集群架构保障,实际计算资源在集群内弹性伸缩;传统服务器不仅不能做到弹性扩展,而且存在单点故障和高成本的缺点安全性:硬件冗余,云端资源调配可有效防御网络攻击,减弱ARP、DDOS攻击影响,并排除单点故障;传统服务器需要依靠人工运维、物理集群(意味着更多投入)来避免以上问题,单点故障无法排除容灾性:存储、备份分布于云端,可能是不同的物理机或是不同数据中心,遇到故障可实现短时间切换并恢复数据;传统服务器存储、备份集中,风险高,备份策略不够灵活扩展性:随时扩展、升级硬件配置,较大程度降低操作成本、减少经费投入;传统服务器扩展能力有限,操作迁移成本高,无法在性能和投入间取得平衡。

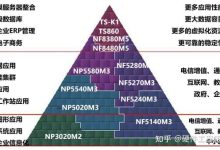

国产云端智能芯片有何特点?

云端智能芯片是面向人工智能领域大规模数据中心和服务器提供的核心芯片。

5月3日,中国科学院发布国内首款云端人工智能芯片,理论峰值速度达每秒128万亿次定点运算,达到世界先进水平,将广泛应用于智能手机、智能音箱、智能摄像头、智能驾驶等不同领域。

智能芯片是前沿科技和社会关注的热点,也是人工智能技术发展过程中不可逾越的关键环节。

可以说,不论有怎样领先的算法,要想最终应用,都必须通过芯片实现。

5月3日,全球新一代人工智能芯片发布会在上海召开,中科院旗下的寒武纪科技公司发布了我国自主研发的Cambricon MLU100云端智能芯片和板卡产品、寒武纪1M终端智能处理器IP产品。

这款国内首个云端人工智能芯片,理论峰值速度达每秒128万亿次定点运算,达到世界先进水平。

智能芯片实现新突破作为此次发布会焦点,首次正式亮相的Cambricon MLU100云端智能芯片,是我国首款云端AI芯片。

据中科院计算所研究员、寒武纪公司创始人兼CEO陈天石介绍,云端智能芯片是面向人工智能领域大规模数据中心和服务器提供的核心芯片。

云端的智能芯片规模更大,结构更加复杂,它和终端芯片的最大区别就在于其运算能力更强。

MLU100云端智能芯片采用寒武纪最新的MLUv01架构和TSMC 16nm的先进工艺,可工作在平衡模式(1GHz主频)和高性能模式(1.3GHz主频)下,平衡模式下的等效理论峰值速度达每秒128万亿次定点运算,高性能模式下的等效理论峰值速度更可达每秒166.4万亿次定点运算,但典型板级功耗仅为80瓦,峰值功耗不超过110瓦。

“3年来,我们从研发两颗测试芯片,一直到现在云端智能芯片的最终亮相,我们时刻准备着‘由端入云’。

”陈天石说,MLU100基于软硬件协同提升内存带宽利用率,不管是从性能比,还是功耗比来说,寒武纪都将树立智能芯片领域的新标杆。

与寒武纪系列终端处理器一样,MLU100云端芯片仍然延续了寒武纪产品一贯出色的通用性,可支持千万量级用户的大规模商用检验,搭载各类深度学习和经典机器学习算法,充分满足视觉、语音、自然语言处理、经典数据挖掘等领域复杂场景下(如大数据量、多任务、多模态、低延时、高通量)的云端智能处理需求。

此外,这次最新发布的寒武纪1M处理器是公司的第三代IP产品,它延续了前两代产品(寒武纪1H/1A)卓越的完备性,单个处理器核即可支持多样化深度学习模型,并更进一步支持经典机器学习算法和本地训练,为视觉、语音、自然语言处理以及各类经典的机器学习任务提供了灵活高效的计算平台,将广泛应用于智能手机、智能音箱、智能摄像头、智能驾驶等不同领域。